toringuyen0509

Well-known member

Năm năm trước, nhà khoa học máy tính Alan Fern và các đồng nghiệp của ông tại Đại học bang Oregon, thuộc thành phố nhỏ Corvallis, đã bắt đầu tìm câu trả lời cho một trong những câu hỏi cấp bách nhất về trí tuệ nhân tạo (AI): Liệu họ có thể hiểu được cách AI suy luận, đưa ra quyết định và lựa chọn hành động của mình hay không?

Con người không giải mã được hướng đi của vài trò chơi có từ năm 1980

Tất nhiên chúng ta có thể đưa ra ngay câu trả lời theo cảm tính: Đó là AI không thể hiểu, không thể ra quyết định và lựa chọn hành động vì AI không phải là người, cũng không đạt được tầm mức như các loài động vật được coi là thông minh nhất. Nhưng ở đây cách tiếp cận của Fern đi theo hướng khác.

Cơ sở chứng minh cho cuộc khám phá của họ là năm trò chơi arcade cổ điển (trò chơi trên máy bỏ tiền xu ở các trung tâm thương mại), vào khoảng năm 1980, bao gồm Pong và Space Invaders. Người chơi là một chương trình máy tính không tuân theo các quy tắc định sẵn mà nó học hỏi bằng cách thử và sai, chơi đi chơi lại các trò chơi đó để phát triển các quy tắc nội bộ để giành chiến thắng, dựa trên những sai lầm trong quá khứ của nó. Các quy tắc này, bởi vì chúng được tạo ra bởi thuật toán, có thể đi ngược lại với trực giác của con người và khó lòng giải mã, nếu không muốn nói là không thể.

Thoạt đầu, Fern và các đồng sự của ông rất lạc quan. Họ đã phát triển các phương pháp để hiểu xem là sự chú ý về mặt hình ảnh của AI đặt trọng tâm vào đâu khi đang chơi trò chơi. Nhưng họ thấy mình gần như không thể tự tin giải mã các chiến lược chiến thắng của nó.

Nhóm của Fern là một trong 11 nhóm đã tham gia dự án có tên AI Giải thích được (Explainable AI), hay XAI, được tài trợ bởi Cơ quan chỉ đạo các Dự án Nghiên cứu Quốc phòng Tiên tiến (DARPA), là bộ phận nghiên cứu và phát triển của Bộ Quốc phòng Hoa Kỳ. Chương trình này, mà đã kết thúc vào năm 2021, phần lớn được thúc đẩy bởi các ứng dụng trong quân sự. Về nguyên tắc, kết quả nghiên cứu sẽ giúp các thành viên của quân đội hiểu, quản lý một cách hiệu quả, gỡ lỗi (debug) và quan trọng là tin tưởng vào một “thế hệ đối tác máy móc trí tuệ nhân tạo mới nổi”, theo sứ mệnh họ đã nêu.

Nhưng các hàm ý của XAI lại vượt xa giới hạn quân sự. Mấy nhà nghiên cứu lo lắng rằng sự thiếu hiểu biết về các hệ thống AI và cách chúng đưa ra quyết định sẽ làm xói mòn niềm tin của tất cả mọi kiểu người dùng. Điều đó có thể không thành vấn đề khi chơi trò chơi điện tử hay biết cách Uber chỉ định tài xế của mình. Ông Fern nói: “Trong phần lớn thời gian, hầu hết mọi người đều không hiểu chút gì về hoạt động bên trong của phần cứng và phần mềm mà họ sử dụng," Ông Fern nhận xét. “Nó đơn giản là ma thuật thôi.”

Nhưng nó lại rất thành vấn đề khi xét tới nhiều lĩnh vực hệ trọng hơn và sự thiếu hiểu biết có thể hạn chế tiện ích của AI—dù là đưa ra quyết định trên chiến trường hay trong bệnh viện. Nó cũng có thể thành vấn đề trong trường hợp các ứng dụng AI tạo sinh ngày càng nổi bật như ChatGPT và GPT-4, có thể tạo ra các bản sao ấn tượng của ngôn ngữ con người—và thậm chí cả dòng mã máy tính—nhưng cũng có thể tạo ra sự sai lệch hoặc sai sót trong suy luận. Luyao Yuan, một nhà khoa học máy tính tại Meta, thành phố New York, người đã làm việc với một nhóm khác trong dự án XAI của DARPA cho biết: “Chỉ khi quá trình ra quyết định minh bạch với người dùng [thì] người dùng mới tin tưởng hoặc dựa vào hệ thống, ngay cả khi hệ thống đó thực sự tốt”.

Matt Turek, một nhà khoa học máy tính của DARPA, người đã giúp điều hành dự án, cho biết kết quả từ chương trình XAI cho thấy có thể không bao giờ có giải pháp chung cho tất cả mọi người để hiểu về AI. Nhưng với việc AI thâm nhập vào gần như mọi khía cạnh trong cuộc sống của chúng ta, thì một số người cho rằng nhiệm vụ mở hộp đen của AI chưa bao giờ hệ trọng hơn thế.

Những con số ẩn giấu

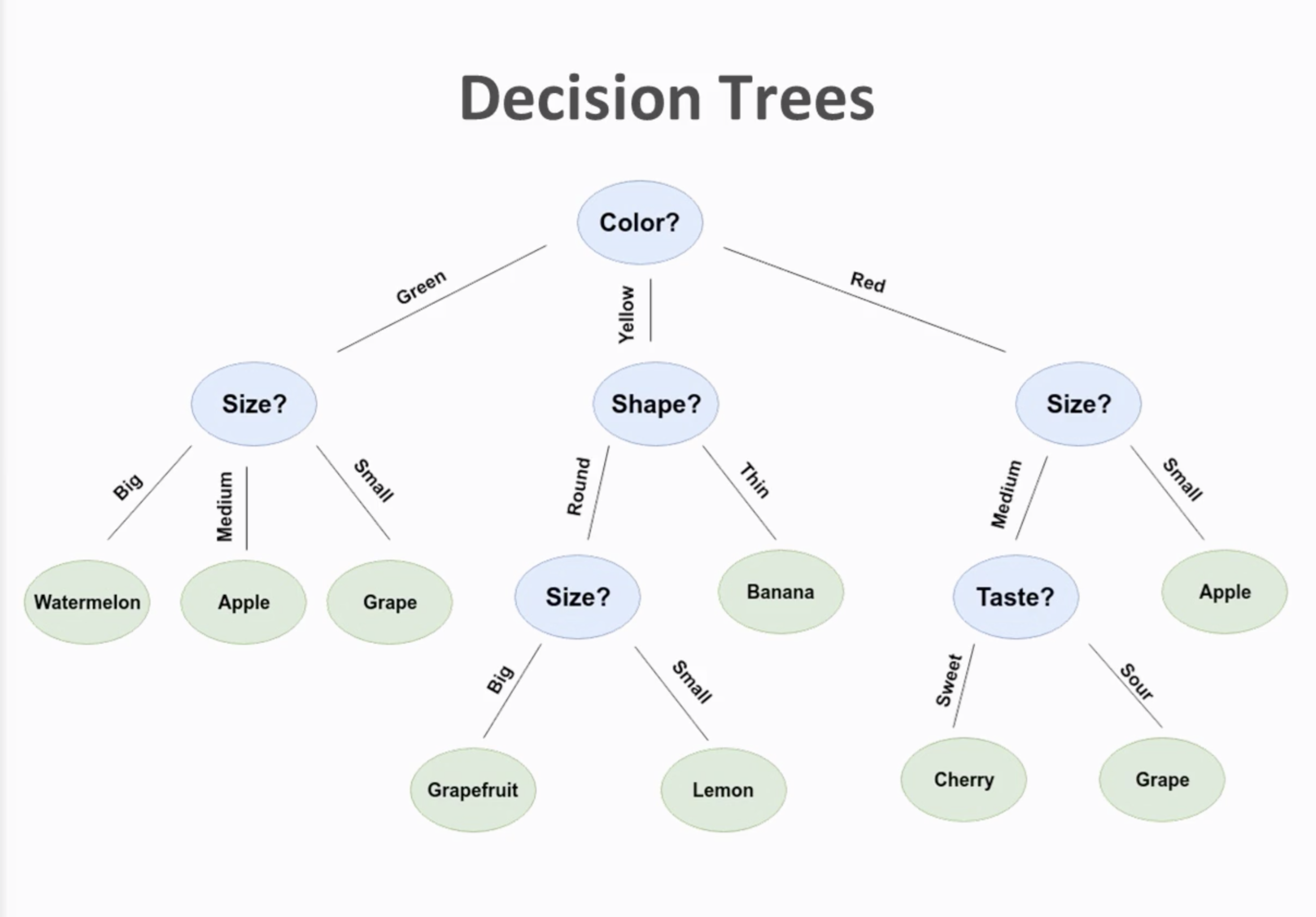

Thuật ngữ “trí tuệ nhân tạo” nhìn chung dùng để nói tới các chương trình máy tính mà chúng xử trí các vấn đề thường do con người giải quyết. Không phải mọi thuật toán như vậy đều phức tạp và mù mờ. Ví dụ, một nhóm các thuật toán được gọi là cây quyết định tuân theo một tập hợp các bài kiểm tra nghiêm ngặt (chẳng hạn, câu hỏi có/không hoặc câu hỏi đúng/sai) để phân loại thông tin và quy trình lập luận của nó là minh bạch. Một người dùng có thể thấy bằng cứ rõ rệt theo từng bước và kết quả có tính xác quyết.

Một thuật toán cây quyết định để xác định loại trái cây. Ở mỗi nút là bài kiểm tra chặt chẽ về màu sắc, kích thước, hình dáng và chỉ có tối đa ba lựa chọn. Nó rất xác quyết: một loại quả nếu màu đỏ thì nó luôn đỏ, không thể vừa đỏ vừa xanh; hoặc đã có kích thước lớn thì luôn lớn, không thể vừa lớn vừa nhỏ, v.v... Quy trình ra quyết định này minh bạch trên từng nút và kết quả rất chính xác. Ảnh: LinkedIn.

Nhưng trong khoảng một thập kỷ qua, sự quan tâm đã bùng nổ đối với các phương pháp AI tinh vi hơn được gọi là mạng lưới thần kinh sâu (deep neural networks) bao gồm các nút tính toán. Các nút được sắp xếp theo nhiều lớp (layer), với một hay nhiều lớp được đặt xen giữa đầu vào và đầu ra. Việc huấn luyện các mạng lưới này—một quá trình được gọi là học sâu—liên quan đến việc điều chỉnh lặp đi lặp lại các trọng số hoặc cường độ của các kết nối giữa các nút, cho đến khi mạng lưới tạo được đầu ra chính xác có thể chấp nhận được cho một đầu vào nhất định.

Nhìn ngay lại sơ đồ cây, nó cũng có các nút tính toán, ra quyết định xen giữa đầu vào và đầu ra. Nhưng nó quá sơ khai khi mà chỉ có 2 hay 3, 4 lựa chọn, và nếu một điều gì đó thực sự đã xảy ra trên nút thì nó có trọng số 100% (yes hay đúng), còn cái không xảy ra đương nhiên là 0% (no hay sai). Còn ở đây là rất nhiều lựa chọn, rất nhiều trọng số, tức là mỗi kết nối giữa các nút có độ mạnh yếu khác nhau. Giống như liên kết giữa các tế bào thần kinh, nên ta gọi là mạng thần kinh, trong khi sơ đồ cây chưa đủ phức tạp để gọi là mạng thần kinh.

Điều này cũng làm cho các mạng lưới sâu trở nên mù mờ. Ví dụ: bất cứ điều gì mà ChatGPT đã học được đều được mã hóa thành hàng…trăm tỷ trọng số bên trong và không thể nào hiểu được việc ra quyết định của AI chỉ bằng cách kiểm tra các trọng số đó.